Nguồn

![]() What is Data Pipeline? | Why Is It So Popular?

What is Data Pipeline? | Why Is It So Popular?

Là gì vậy?

Trong thế giới hiện đại, các công ty thu thập lượng lớn dữ liệu từ nhiều nguồn khác nhau. Dữ liệu này rất quan trọng để đưa ra các quyết định kinh doanh sáng suốt và thúc đẩy sự đổi mới. Tuy nhiên, dữ liệu thô thường rất lộn xộn, không có cấu trúc và được lưu trữ ở nhiều định dạng khác nhau trong các hệ thống khác nhau. Data pipelines tự động hóa quá trình thu thập, chuyển đổi và phân phối dữ liệu để làm cho nó trở nên hữu ích và có giá trị.

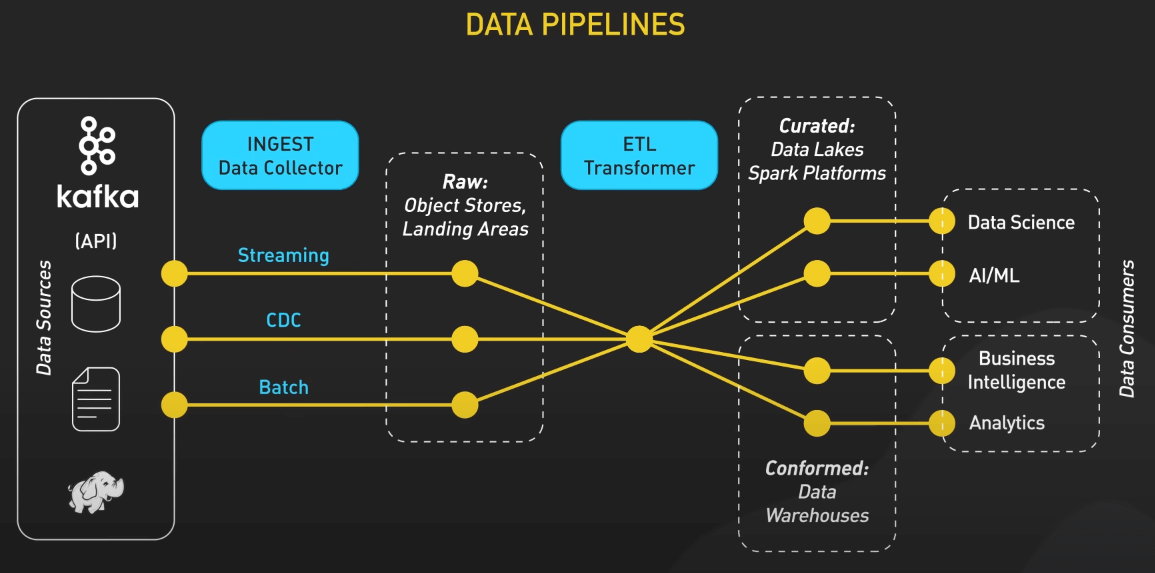

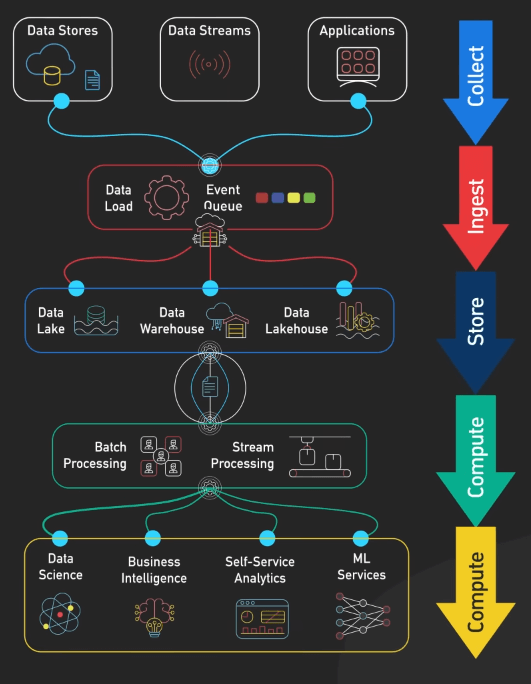

Data pipelines có rất nhiều dạng khác nhau. Thuật ngữ này bao quát bất kỳ quy trình nào di chuyển một lượng lớn dữ liệu từ nơi này đến nơi khác. Ở đây, chúng ta sẽ xem xét một phiên bản tổng quát, nhưng đây không phải là cách duy nhất để triển khai một data pipeline hiệu quả. Nhìn chung, một data pipeline có các giai đoạn chính: thu thập, tiếp nhận, lưu trữ, tính toán, và tiêu thụ. Thứ tự của các giai đoạn này có thể thay đổi dựa trên loại dữ liệu, nhưng chúng thường bao gồm tất cả các giai đoạn này.

Thu thập

Hãy tưởng tượng chúng ta đang làm việc cho một gã khổng lồ thương mại điện tử như Amazon. Dữ liệu sẽ đổ về từ nhiều nguồn: data store, data stream và các ứng dụng. Data store là các cơ sở dữ liệu như MySQL, Postgres, hoặc DynamoDB, nơi các bản ghi transaction được lưu trữ. Ví dụ, mỗi lần đăng ký người dùng, đặt hàng, và thanh toán sẽ được lưu vào các cơ sở dữ liệu này. Data stream thu nhận các luồng dữ liệu trực tiếp, như việc theo dõi các lượt nhấp chuột và tìm kiếm của người dùng trong thời gian thực, với các công cụ như Apache Kafka hoặc Amazon Kinesis, hoặc dữ liệu đến từ các thiết bị IoT.

Tiếp nhận

Với các nguồn dữ liệu đa dạng này, giai đoạn tiếp theo là ingest (tiếp nhận), nơi dữ liệu được tải vào môi trường của data pipeline. Tùy vào loại dữ liệu, dữ liệu có thể được tải trực tiếp vào pipeline xử lý hoặc vào một hàng đợi sự kiện trung gian. Các công cụ như Apache Kafka hoặc Amazon Kinesis thường được sử dụng cho luồng dữ liệu thời gian thực. Dữ liệu từ các cơ sở dữ liệu thường được tiếp nhận thông qua các quy trình xử lý theo đợt hoặc các công cụ Change Data Capture (CDC). Sau khi tiếp nhận, dữ liệu có thể được xử lý ngay hoặc lưu trữ trước, tùy thuộc vào các use case cụ thể.

Tính toán

Giai đoạn tiếp theo là compute (tính toán), nơi dữ liệu được xử lý và biến đổi thành định dạng có thể phân tích. Có hai loại xử lý chính là xử lý theo lô và xử lý theo dòng:

- Batch Processing (Xử lý theo lô): Liên quan đến việc xử lý khối lượng lớn dữ liệu vào những thời điểm được lên lịch trước. Apache Spark, với khả năng tính toán phân tán, đóng vai trò quan trọng ở đây. Các công cụ xử lý theo lô khác bao gồm Apache Hadoop MapReduce và Apache Hive. Ví dụ, các job Spark có thể được cấu hình để chạy hàng đêm, nhằm tổng hợp dữ liệu bán hàng hàng ngày.

- Stream Processing (Xử lý theo dòng): Dùng để xử lý dữ liệu theo thời gian thực. Các công cụ như Apache Flink, Google Cloud Dataflow, Apache Storm hoặc Apache Samza xử lý dữ liệu ngay khi dữ liệu đến. Ví dụ, Flink có thể được sử dụng để phát hiện các giao dịch gian lận theo thời gian thực bằng cách phân tích các luồng giao dịch và áp dụng các quy tắc xử lý sự kiện phức tạp.

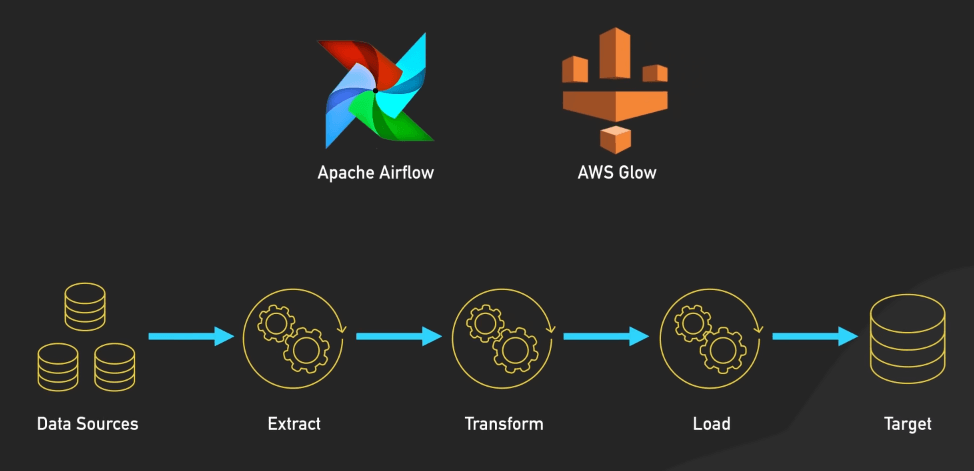

Trong giai đoạn này, quy trình ETL hoặc ELT cũng đóng vai trò quan trọng. Các công cụ ETL như Apache Airflow và AWS Glue giúp điều phối việc nạp dữ liệu, đảm bảo các thao tác chuyển đổi như làm sạch dữ liệu, chuẩn hóa và làm phong phú dữ liệu được thực hiện trước khi tải vào lớp lưu trữ. Đây là giai đoạn mà dữ liệu lộn xộn, không có cấu trúc và không đồng nhất được chuyển đổi thành một định dạng sạch sẽ, có cấu trúc, phù hợp để phân tích.

Lưu trữ

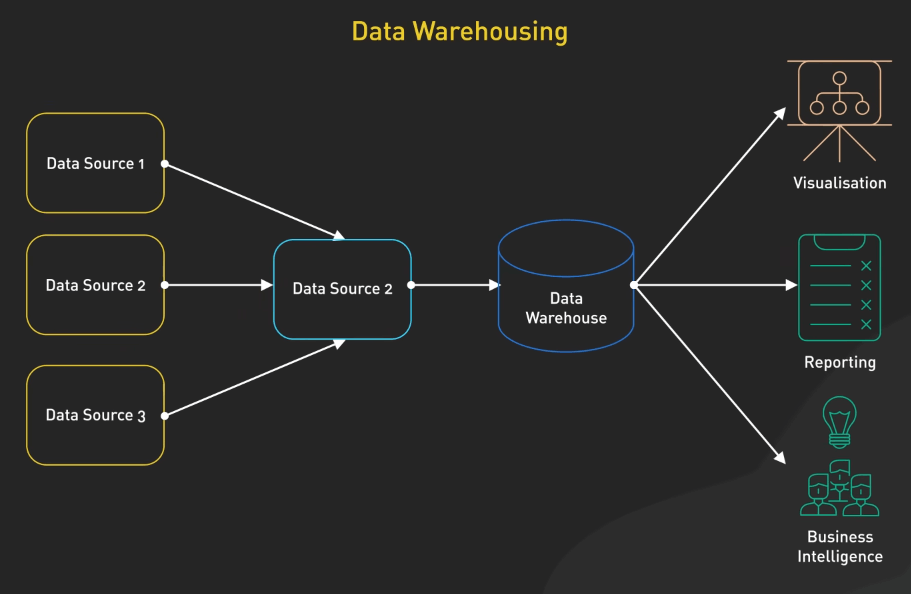

Sau khi xử lý, dữ liệu sẽ chảy vào storage (lưu trữ). Ta có một số lựa chọn như:

- Data Lake (hồ dữ liệu): Lưu trữ dữ liệu thô, chưa qua xử lý, thường sử dụng các công cụ như Amazon S3 hoặc HDFS. Dữ liệu thường được lưu trữ ở các định dạng như Parquet hoặc Avro, các định dạng này rất hiệu quả cho lưu trữ và truy vấn quy mô lớn.

- Data Warehouse (kho dữ liệu): Lưu trữ dữ liệu đã qua xử lý, có cấu trúc, chẳng hạn như Snowflake, Amazon Redshift hoặc Google BigQuery.

- Data Lakehouse: Kết hợp các tính năng của cả data lake và data warehouse, hỗ trợ cả dữ liệu thô và có cấu trúc.

Tiêu thụ

Cuối cùng, dữ liệu đã qua xử lý sẵn sàng cho giai đoạn consume (tiêu thụ). Các team sử dụng dữ liệu cho các mục đích khác nhau:

Data Science Teams (Các team khoa học dữ liệu): Sử dụng dữ liệu cho mô hình dự đoán. Các công cụ phổ biến là Jupyter Notebooks với các thư viện như TensorFlow hoặc PyTorch. Các nhà khoa học dữ liệu có thể xây dựng các mô hình để dự đoán tỷ lệ rời bỏ khách hàng dựa trên dữ liệu tương tác lịch sử được lưu trữ trong kho dữ liệu.

Business Intelligence Tools (Các công cụ phân tích kinh doanh): Các công cụ như Tableau hoặc Power BI cung cấp bảng điều khiển và báo cáo tương tác. Các công cụ này kết nối trực tiếp với data warehouses hoặc lakehouses, cho phép các nhà lãnh đạo doanh nghiệp xem KPI và xu hướng.

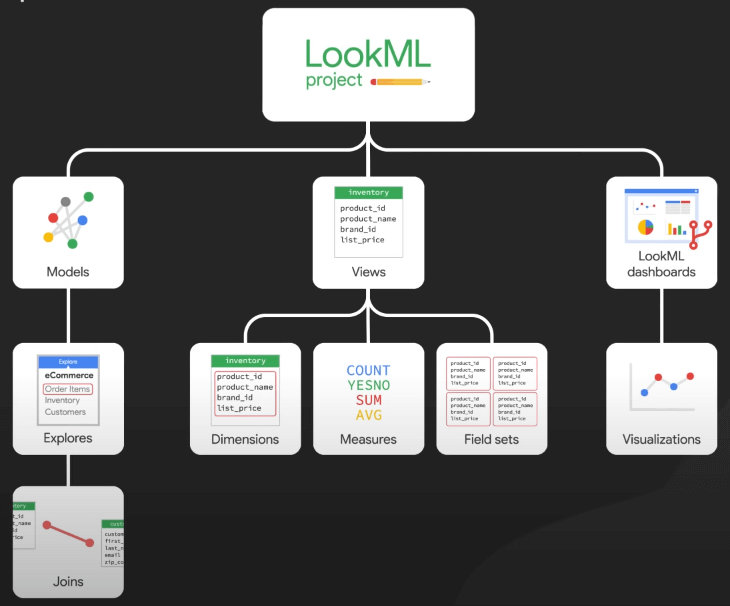

- Self-Service Analytics Tools (Công cụ phân tích tự phục vụ): Các công cụ như Looker cho phép các team tự chạy truy vấn mà không cần kiến thức kỹ thuật sâu. LookML, ngôn ngữ mô hình của Looker, giúp đơn giản hóa SQL, cho phép các team như marketing phân tích hiệu suất chiến dịch.

- Machine Learning Models (Các mô hình học máy): Sử dụng dữ liệu này để học liên tục và cải tiến. Ví dụ, các mô hình phát hiện gian lận ngân hàng liên tục được đào tạo với dữ liệu giao dịch mới để thích ứng với các pattern gian lận hiện nay.

Website không chứa bất kỳ quảng cáo nào, mọi đóng góp để duy trì phát triển cho website (donation) xin vui lòng gửi về STK 90.2142.8888 - Ngân hàng Vietcombank Thăng Long - TRAN VAN BINH

=============================

Nếu bạn không muốn bị AI thay thế và tiết kiệm 3-5 NĂM trên con đường trở thành DBA chuyên nghiệp hay làm chủ Database thì hãy đăng ký ngay KHOÁ HỌC ORACLE DATABASE A-Z ENTERPRISE, được Coaching trực tiếp từ tôi với toàn bộ bí kíp thực chiến, thủ tục, quy trình của gần 20 năm kinh nghiệm (mà bạn sẽ KHÔNG THỂ tìm kiếm trên Internet/Google) từ đó giúp bạn dễ dàng quản trị mọi hệ thống Core tại Việt Nam và trên thế giới, đỗ OCP.

- CÁCH ĐĂNG KÝ: Gõ (.) hoặc để lại số điện thoại hoặc inbox https://m.me/tranvanbinh.vn hoặc Hotline/Zalo 090.29.12.888

- Chi tiết tham khảo:

https://bit.ly/oaz_w

=============================

2 khóa học online qua video giúp bạn nhanh chóng có những kiến thức nền tảng về Linux, Oracle, học mọi nơi, chỉ cần có Internet/4G:

- Oracle cơ bản: https://bit.ly/admin_1200

- Linux: https://bit.ly/linux_1200

=============================

KẾT NỐI VỚI CHUYÊN GIA TRẦN VĂN BÌNH:

📧 Mail: binhoracle@gmail.com

☎️ Mobile/Zalo: 0902912888

👨 Facebook: https://www.facebook.com/BinhOracleMaster

👨 Inbox Messenger: https://m.me/101036604657441 (profile)

👨 Fanpage: https://www.facebook.com/tranvanbinh.vn

👨 Inbox Fanpage: https://m.me/tranvanbinh.vn

👨👩 Group FB: https://www.facebook.com/groups/DBAVietNam

👨 Website: https://www.tranvanbinh.vn

👨 Blogger: https://tranvanbinhmaster.blogspot.com

🎬 Youtube: https://www.youtube.com/@binhguru

👨 Tiktok: https://www.tiktok.com/@binhguru

👨 Linkin: https://www.linkedin.com/in/binhoracle

👨 Twitter: https://twitter.com/binhguru

👨 Podcast: https://www.podbean.com/pu/pbblog-eskre-5f82d6

👨 Địa chỉ: Tòa nhà Sun Square - 21 Lê Đức Thọ - Phường Mỹ Đình 1 - Quận Nam Từ Liêm - TP.Hà Nội

=============================

cơ sở dữ liệu, cơ sở dữ liệu quốc gia, database, AI, trí tuệ nhân tạo, artificial intelligence, machine learning, deep learning, LLM, ChatGPT, DeepSeek, Grok, oracle tutorial, học oracle database, Tự học Oracle, Tài liệu Oracle 12c tiếng Việt, Hướng dẫn sử dụng Oracle Database, Oracle SQL cơ bản, Oracle SQL là gì, Khóa học Oracle Hà Nội, Học chứng chỉ Oracle ở đầu, Khóa học Oracle online,sql tutorial, khóa học pl/sql tutorial, học dba, học dba ở việt nam, khóa học dba, khóa học dba sql, tài liệu học dba oracle, Khóa học Oracle online, học oracle sql, học oracle ở đâu tphcm, học oracle bắt đầu từ đâu, học oracle ở hà nội, oracle database tutorial, oracle database 12c, oracle database là gì, oracle database 11g, oracle download, oracle database 19c/21c/23c/23ai, oracle dba tutorial, oracle tunning, sql tunning , oracle 12c, oracle multitenant, Container Databases (CDB), Pluggable Databases (PDB), oracle cloud, oracle security, oracle fga, audit_trail,oracle RAC, ASM, oracle dataguard, oracle goldengate, mview, oracle exadata, oracle oca, oracle ocp, oracle ocm , oracle weblogic, postgresql tutorial, mysql tutorial, mariadb tutorial, ms sql server tutorial, nosql, mongodb tutorial, oci, cloud, middleware tutorial, docker, k8s, micro service, hoc solaris tutorial, hoc linux tutorial, hoc aix tutorial, unix tutorial, securecrt, xshell, mobaxterm, putty